Se você quiser aprender como usar o codificador DeepSeek V3 no Windows 11 , esta postagem irá guiá-lo. DeepSeek-V3 Coder é uma versão especializada do modelo DeepSeek-V3. Ele aproveita o processamento de linguagem natural e técnicas avançadas de aprendizado de máquina para compreender e gerar código, fornecer assistência de programação e ajudar os usuários nas tarefas de desenvolvimento de software.

Como usar o codificador DeepSeek V3 no Windows 11?

DeepSeek V3 Coder é para quem procura melhorar suas habilidades de codificação ou agilizar seu processo de desenvolvimento de software. Se você quiser use o codificador DeepSeek V3 no Windows 11 , você pode acessá-lo através do plataforma de demonstração on-line , API serviço ou faça o download dos pesos do modelo para implantação local . Vamos ver como.

1] Acesse o codificador DeepSeek-V3 via navegador da web

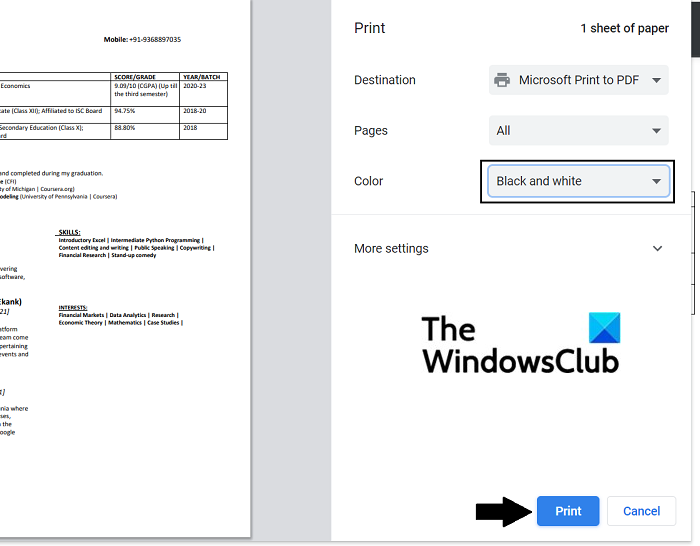

Inicie seu navegador favorito, digite www.deepseekv3.com na barra de URL e pressione Enter. Você será redirecionado para o site oficial do DeepSeek. Clique no ‘ Experimente o DeepSeek V3 'botão no canto superior direito.

Você verá a interface de bate-papo do DeepSeek. Digite sua consulta na caixa de entrada do chat e pressione Digitar . DeepSeek V3 irá gerar rapidamente uma resposta para você.

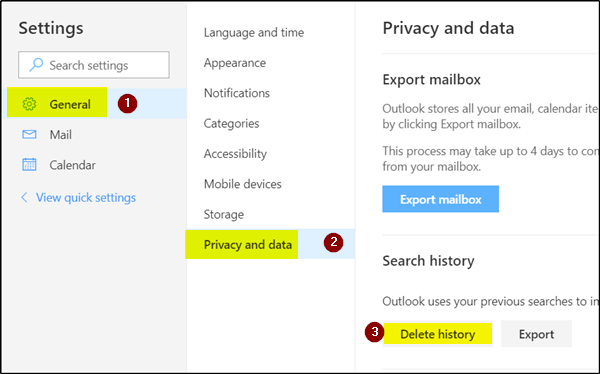

Registre-se no DeepSeek para obter acesso a recursos premium ou opções avançadas, como salvar histórico de bate-papo ou personalizar preferências.

papel de parede cromado

Tipo chat.deepseek.com na barra de URL do seu navegador e pressione Digitar . Em seguida, inscreva-se para uma conta DeepSeek. Após o login, você verá uma interface de bate-papo baseada no modelo DeepSeek-V3 mais recente. Você pode usar a interface para inserir suas consultas de codificação, gerar código ou depurar programas.

2] Acesse o codificador DeepSeek-V3 via API

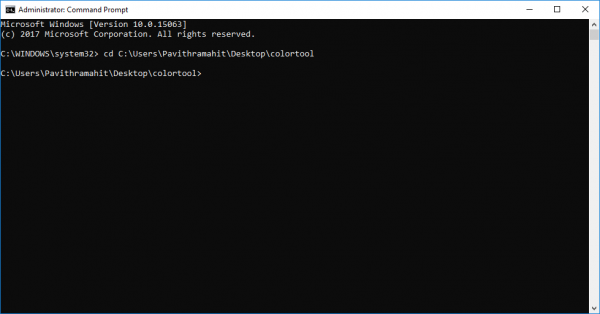

Para acessar o modelo DeepSeek-V3 via API no Windows 11, siga estas etapas:

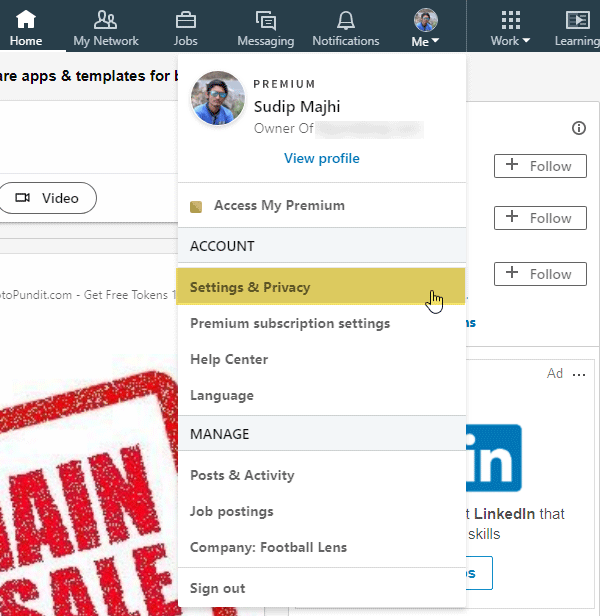

Registre-se para uma conta na plataforma DeepSeek para receber sua chave API.

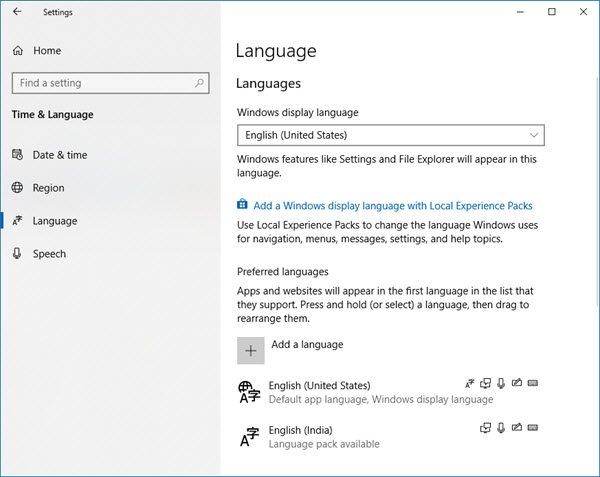

ajustes de sistema permitem múltiplas sessões ts

Baixe e instale o Python em python.org , se ainda não estiver instalado. Durante a instalação, certifique-se de marcar a caixa para Adicione python.exe ao PATH (se Python for adicionado ao PATH, você pode simplesmente digitar python ou pip em qualquer janela de terminal, e o sistema saberá onde encontrar o interpretador Python ou gerenciador de pacotes. Sem adicionando Python ao PATH, você precisará navegar até o diretório específico onde o Python está instalado, toda vez que desejar executar um comando Python).

Em seguida, instale o SDK apropriado.

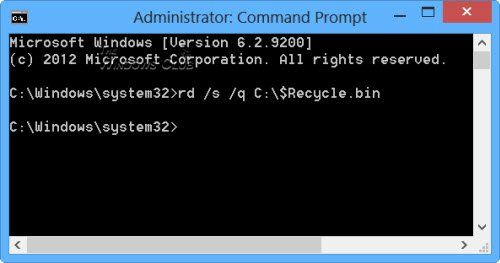

A API DeepSeek usa um formato de API compatível com OpenAI, então você pode acessar a API DeepSeek usando o SDK OpenAI ou qualquer software compatível com API OpenAI. Para instalar o OpenAI SDK, abra o prompt de comando e execute o seguinte comando:

pip install openai

Depois que seu ambiente de desenvolvimento estiver configurado, configure o acesso à API enquanto define o URL base para:

'https://api.deepseek.com'

Em seguida, acesse o modelo DeepSeek V3 fazendo chamadas de API. Aqui está um exemplo Python para interagir com o modelo DeepSeek V3:

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)Observação:

- O nome do modelo

deepseek-chatinvocará o DeepSeek V3. - Habilite o streaming configurando

'stream=true'. O streaming é ideal para cenários de resposta em tempo real.

3] Acesse o codificador DeepSeek-V3 por meio de implantação local

A implantação local do DeepSeek V3 envolve o download dos pesos do modelo e a configuração do ambiente necessário. No entanto, não existe um documento oficial do DeepSeek V3 especificamente adaptado para implantar o modelo localmente no Windows 11. O guias de implantação disponíveis focar principalmente em Linux ambientes, especialmente Ubuntu 20.04 ou superior .

Para implantação local do DeepSeek-V3 Coder no Windows 11, você pode criar um ambiente semelhante ao Linux em seu sistema Windows.

Antes de continuar, certifique-se de que seu sistema atenda a estes requisitos mínimos de hardware e software:

- GPU: GPU NVIDIA com suporte CUDA (por exemplo, série RTX 30xx ou superior).

- Pitão: Versão 3.8 ou superior.

- Memória: Pelo menos 16 GB de RAM (32 GB recomendado).

- CUDA e cuDNN: Instale as versões compatíveis com as dependências do DeepSeek V3.

Agora siga estas etapas:

usuário

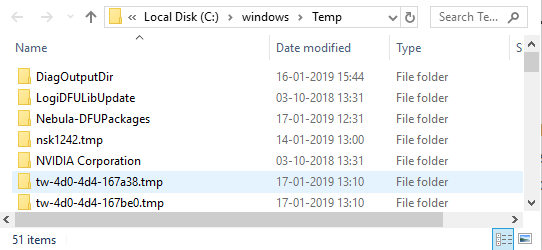

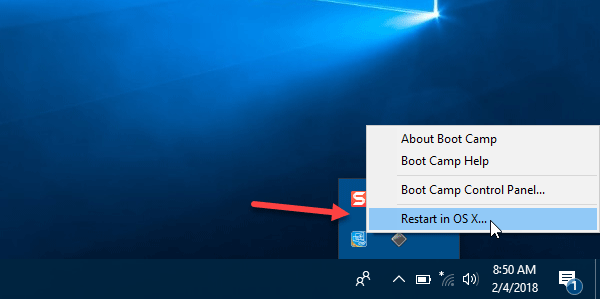

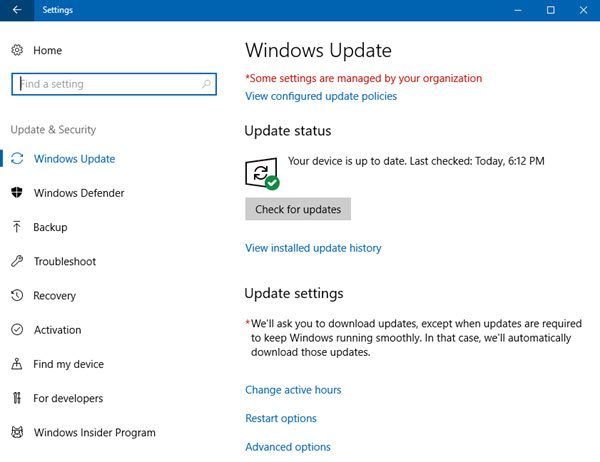

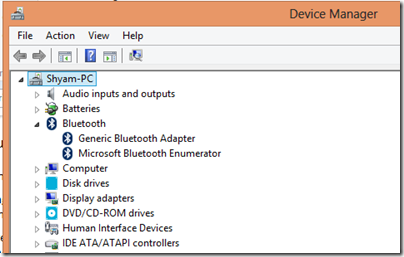

Instale o subsistema Windows para Linux 2 em seu PC com Windows 11 .

Clone o repositório DeepSeek V3:

git clone https://github.com/deepseek-ai/DeepSeek-V3.git

Navegue até o diretório de inferência e instale as dependências listadas em requirements.txt:

cd DeepSeek-V3/inference pip install -r requirements.txt

Próximo, baixe os pesos do modelo de Abraçando o rosto e coloque-os na pasta /path/to/DeepSeek-V3.

A seguir, converta os pesos do modelo para um formato específico:

python convert.py --hf-ckpt-path /path/to/DeepSeek-V3 --save-path /path/to/DeepSeek-V3-Demo --n-experts 256 --model-parallel 16

Agora você pode conversar com DeepSeek-V3 ou inferência em lote em um determinado arquivo.

pesquisa falhou ocorreu um erro enquanto o Chrome procurava por software prejudicial

É isso! Espero que você ache isso útil.

Ler: Melhores assistentes geradores de código AI para código VS .

O DeepSeek é gratuito?

DeepSeek fornece acesso gratuito a determinados modelos, permitindo que os usuários experimentem seus recursos sem custo imediato. Outros modelos operam de forma paga, com custos determinados pela utilização. O modelo mais recente, DeepSeek-V3, tem uma estrutura de preços de US$ 0,14 por milhão de tokens de entrada e US$ 0,28 por milhão de tokens de saída (há um desconto contínuo nos preços do DeepSeek-V3 até 8 de fevereiro de 2025).

Qual GPU você precisa para o DeepSeek Coder V2?

A implantação do DeepSeek-Coder-V2 requer recursos substanciais de GPU devido ao grande tamanho e complexidade do modelo. Para inferência no formato BF16 (bfloat16), o modelo necessita de 8 GPUs, cada uma equipada com 80 GB de memória.

Leia a seguir: Melhores ferramentas de IA de captura de tela para código .